Le prochain niveau du trading algorithmique avec le Reinforcement Learning

Découvrez comment le reinforcement learning booste le trading crypto : IA adaptative, exemple PPO sur Bitcoin et rendement supérieur au buy & hold.

On parle souvent de backtests, d’indicateurs techniques, de gestion du risque... mais avez-vous déjà envisagé de laisser une IA apprendre à trader toute seule ?

C’est exactement ce que permet le reinforcement learning (apprentissage par renforcement) : une approche où un agent (votre futur bot IA) explore le marché, fait des erreurs, apprend de ses gains et finit par découvrir sa propre stratégie.

🧠 Ce n’est pas de la magie : c’est de l’intelligence artificielle. Et c’est probablement la technologie la plus prometteuse pour créer des bots de trading adaptatifs, capables de s’ajuster à un marché aussi volatil et imprévisible que les cryptos.

Dans cet article, on vous explique :

- Comment fonctionne le reinforcement learning appliqué au trading

- Pourquoi cette approche est particulièrement pertinente pour les crypto-actifs

Reinforcement Learning : trader comme un joueur d’échecs

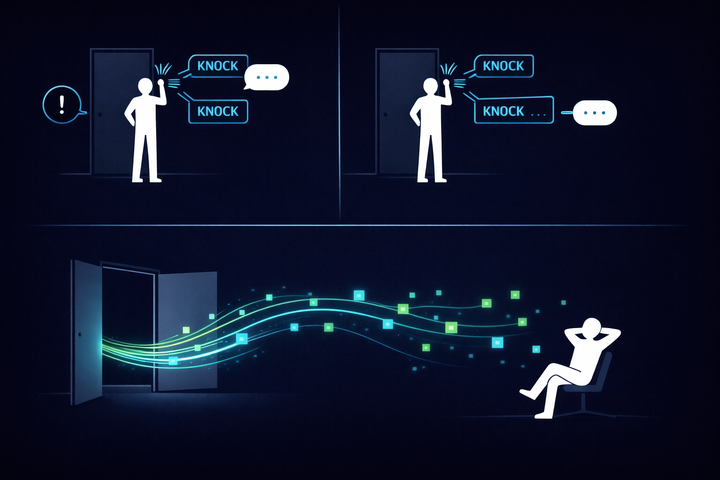

Le trading algorithmique consiste à prendre des décisions d’achat/vente basées sur des modèles informatiques, souvent à grande vitesse et sur de vastes volumes de données. L’apprentissage par renforcement (reinforcement learning, ou RL) est une branche de l’IA où un agent apprend par essais-erreurs à maximiser une récompense en interagissant avec un environnement. Appliqué au trading, le marché financier devient l’environnement, et le profit (ajusté du risque) fait office de récompense. L’agent RL peut exécuter des actions telles que « acheter », « vendre » ou « conserver », puis observe l’effet sur son portefeuille et ajuste sa stratégie au fil du temps.

À la base, le reinforcement learning vient du monde du jeu : c’est cette technique qui a permis à AlphaGo de battre les meilleurs joueurs de Go. Son principe est simple : un agent (le joueur) essaie des actions (déplacements), observe ce qu’il se passe (gagner/perdre), puis améliore ses décisions avec l’expérience.

➡️ Transposez ça au trading, et vous obtenez un bot qui apprend à acheter, vendre ou ne rien faire selon l’état du marché, avec comme seule boussole : maximiser ses gains dans le temps.

Pourquoi c’est adapté aux cryptos ?

Le marché crypto est :

- Ouvert 24h/24 → idéal pour que l’agent ait toujours de nouvelles données à apprendre

- Très volatil → ce qui génère énormément de signaux et de situations variées

- Moins régulé et plus jeune → donc potentiellement plus "apprenable" qu’un marché mature

Mais il est aussi plus bruité, donc plus difficile à modéliser avec des approches classiques.

Un agent de reinforcement learning, lui, ne cherche pas à prédire : il agit, observe les conséquences, apprend. Et c’est exactement ce dont on a besoin ici.

Concrètement, ça ressemble à quoi ? (Exemple avec PPO)

🧪 On vous propose un exemple simple d’algorithme de reinforcement learning : PPO (Proximal Policy Optimization). C’est l’un des algos les plus stables et robustes du domaine.

🧰 On l’a intégré dans un environnement de simulation qui joue avec les prix du Bitcoin heure par heure.

👉 L’environnement :

- Données BTC/USD (par exemple sur Binance, timeframe 1h)

- L’agent peut acheter, vendre ou attendre

- À chaque action, il reçoit une récompense (positive s’il a gagné de l’argent, négative sinon)

👉 L’algorithme PPO :

- Apprend une "politique" (c’est-à-dire une stratégie probabiliste)

- Met à jour sa stratégie pas à pas, tout en évitant les changements trop brutaux

- Est particulièrement adapté aux marchés financiers, car il permet d’ajuster des positions continues (par exemple : allouer 40 % de capital à une position long, 60 % en stablecoin)

Résultat d’un entraînement : 🎯

Après quelques milliers d’épisodes d’apprentissage, l’agent PPO est capable de :

- Identifier les phases de tendance pour entrer en position

- Rester à l’écart en période de forte incertitude

- Réaliser un rendement cumulé positif, supérieur à une stratégie buy & hold sur la période testée

📊 Bien sûr, ce n’est qu’un prototype. Mais il démontre que l’agent est capable d’apprendre seul, uniquement avec les prix et ses résultats passés comme feedback.

Le mot de la fin

On le répète souvent : optimiser un bot ne consiste pas seulement à ajuster les paramètres d’un indicateur.

C’est repenser complètement la manière de prendre des décisions.

Avec le reinforcement learning, on ne donne pas une stratégie au bot. On lui apprend à la découvrir par lui-même. Et ça change tout.

Ce n’est pas encore la solution miracle — il y a des limites, notamment en production réelle — mais c’est une piste incroyablement riche à explorer pour ceux qui veulent aller plus loin que les règles fixes et les backtests rigides.

Commentaires ()